交叉熵

https://blog.csdn.net/tsyccnh/article/details/79163834

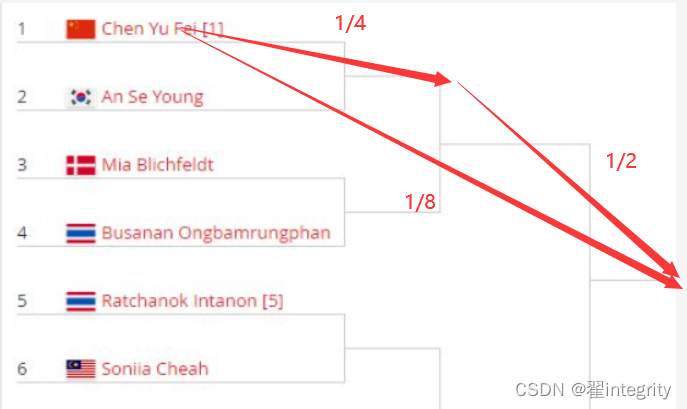

我们可以得出f(1/8)=f(1/4)+f(1/2) 那么我们应该怎么写才能自洽 这里我们可以知道1/8,1/4,1/2,都是概率。 p(中国队夺冠)=p(中国队进决赛)p(中国队赢得决赛) 所以这几个式子完全满足才能自洽。得出 f(x1x2)=f(x1)+f(x2) 那么相乘怎么得出相加呢,所以这个f(x): = (信息量)必须有一个log

f(1/8)=f(1/4)+f(1/2)

仔细想一下在这里信息量是不能直接相加的这里是各个球队赢球的话信息量是这么多所以前面要乘以概率得出各个球队队系统贡献量

观察上面公式子可以得出信息量乘以占比再相加 ,就是相当于求期望。

然后我们可以对熵进行定义,假如说一个概率系统p,熵就是定义成对这个系统求期望。

https://blog.csdn.net/tsyccnh/article/details/79163834

definition

(Cross Entropy)是Shannon信息论中一个重要概念,主要用于度量两个概率分布间的差异性信息。在信息论中,交叉熵是表示两个概率分布 p,q 的差异,其中 p 表示真实分布,q 表示预测分布。

交叉熵可在神经网络中作为损失函数